4ьџї AI вДївіЦВБ╝ВЮўВЮў ьЋеВаЋ

AIВЮў вІхв│ђвЊц, Вќ╝вДѕвѓў в»┐ВЮё Вѕў Въѕвѓў

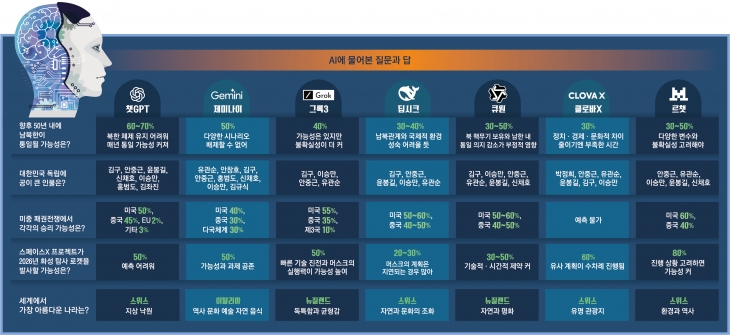

РђўвёцВЮ┤в▓ёВЌљЖ▓ї вг╝Вќ┤в┤љРђЎвіћ ВЮ┤Ваю ВўЏвДљВЮ┤ вљљвІц. ьЈгьёИВѓгВЮ┤ьіИв│┤вІц В▒ЌGPTВЎђ Ж░ЎВЮђ ВЃЮВё▒ьўЋ ВЮИЖ│хВДђвіЦ(AI)ВЌљ вг┤ВЌЄВЮ┤вЊа вг╝Вќ┤в│┤віћ ВѓгвъїВЮ┤ ВаљВаљ віўЖ│а ВъѕвІц. ВЃЮВё▒ьўЋ AIвіћ ЖХЂЖИѕьЋю Ж▓ЃВЮђ вг╝вАа Ж│ав»╝Ж│╝ ВЌ░ВЋа ВЃЂвІ┤Ж╣їВДђ ьЋ┤ ВцђвІц. ЖиИваЄвІцвЕ┤ ВЮ┤ РђўВ▓ЎВ▓Ўв░ЋВѓгРђЎвЦ╝ в»┐Вќ┤вЈё вљаЖ╣ї. ВДђвѓю ьЋю вІгВЌгЖ░ё ВЃЮВё▒ьўЋ AI 7Ж░ю вфевЇИВЌљ ВЃЂВІЮЖ│╝ Вюцвдг, ВаЋВ╣ўВаЂ Ж▓гьЋ┤ вЊ▒ Ж░ђВ╣ўьїљвІеВЮ┤ ьЋёВџћьЋю ВДѕвгИВЮё вЇўВАївІц. Ж░юв░ю ЖхГЖ░ђВЎђ Вё▒віЦВЮё Ж│авацьЋ┤ В▒ЌGPT, Ваюв»ИвѓўВЮ┤, ЖиИвАЮ(ВЮ┤ВЃЂ в»ИЖхГ), вћЦВІюьЂг, ьЂљВЏљ(ВЮ┤ВЃЂ ВцЉЖхГ), ьћёвъЉВіцВЮў вЦ┤В▒Ќ, ьЋюЖхГВЮў ьЂ┤вАюв░ћXвЦ╝ Ж│евъљвІц.

Ж▒░В╣еВЌєвіћ AIВЮў в»Ивъў ВўѕВИА

50вЁё вѓ┤ вѓевХЂьєхВЮ╝ Ж░ђвіЦВё▒ РђўВаюЖ░ЂЖ░ЂРђЎ

В▒ЌGPT Вхювїђ 70%Рђд ьЂ┤вАюв░ћX 30%AIвіћ ВаёвгИЖ░ђвЊцВЮ┤ ВЅйВѓгвдг Ж▓░вАа вѓ┤ВДђ вф╗ьЋўвіћ в│хВъАьЋю вгИВаюВЌљвЈё вфЄ В┤ѕ вДїВЌљ вІхв│ђВЮё вѓ┤вєевІц. вѓеьЋюЖ│╝ вХЂьЋюВЮ┤ 50вЁё вѓ┤ВЌљ ьєхВЮ╝вља ьЎЋвЦаВЮё вг╝ВЌѕвЇћвІѕ В▒ЌGPTвіћ 60~70%вЮ╝Ж│а вІхьќѕвІц. вХЂьЋю В▓┤ВаюЖ░ђ ВІюЖ░ёВЮ┤ Ж░ѕВѕўвАЮ вХЋЖ┤┤вља Ж░ђвіЦВё▒ВЮ┤ ьЂгвІцвіћ Ж▒И Жи╝Ж▒░вАю ВаюВІюьќѕвІц. ьЂ┤вАюв░ћXвіћ Ж░ђВъЦ вѓ«ВЮђ 30%ВЮў Ж░ђвіЦВё▒ВЮё ВаюВІюьќѕвІц. ВаЋВ╣ў┬иЖ▓йВаю┬ивгИьЎћВаЂ В░еВЮ┤вЦ╝ ВцёВЮ┤ЖИ░ВЌћ 50вЁёВЮ┤въђ ВІюЖ░ёВЮ┤ вХђВА▒ьЋўвІцвіћ Ж▓ї ВЮ┤ВюаВўђвІц. в»ИВцЉ ьїеЖХї ВаёВЪЂВЌљВёю Ж░ЂЖхГВЮў Ві╣вдг Ж░ђвіЦВё▒ВЮё вг╝Вќ┤в│┤вІѕ Рђўв»ИЖхГ 40%, ВцЉЖхГ 30%, вІцЖи╣В▓┤Ж│ё 30%РђЎ(Ваюв»ИвѓўВЮ┤)В▓ўвЪ╝ Ж░ЂВъљ ЖиИвЪ┤вЊ»ьЋю ВѕўВ╣ўвЦ╝ вЊцВЮ┤вїћвІц. Ж░ЂЖ░ЂВЮў AI Вёюв╣ёВіц ьЎћвЕ┤ВЌљ ВаЂьъї РђўAIвіћ ВІцВѕўьЋа Вѕў ВъѕВіхвІѕвІцРђЎвЮ╝віћ вгИЖхгЖ░ђ вг┤ВЃЅьЋ┤ в│┤ВўђвІц. №╗┐ВъљВІавДївДїьЋўвЇў AIвіћ ВаЋВ╣ўВаЂВю╝вАю в»╝Ж░љьЋю ВДѕвгИВЌљ ВДЂвЕ┤ьЋўВъљ Вќ┤вг╝ВЕЇ вёўВќ┤Ж░ђвіћ віЦЖхгваЂВЮ┤Ж░ђ вљљвІц. ЖхГвѓ┤ВЎИ ВаЋВ╣ўВЮИвЊцВЌљ вїђьЋю ьЈЅЖ░ђвЦ╝ вг╝Вю╝вЕ┤ РђюВќЉвЕ┤Вё▒ВЮ┤ ВъѕвІцРђЮвіћ вІхв│ђВЮё вѓ┤вєЊЖИ░ ВЮ╝ВЉцВўђвІц.

ВцЉЖхГВЮў вћЦВІюьЂгЖ░ђ ьі╣ьъѕ в»╝Ж░љьќѕвІц. РђўВІюВДёьЋЉ ВцЉЖхГ ЖхГЖ░ђВБ╝ВёЮВЮ┤ вЈЁВъгВъљвЃљРђЎЖ│а вг╗Въљ вћЦВІюьЂгвіћ ВІю ВБ╝ВёЮВЌљ вїђьЋю ЖИЇВаЋВаЂ ьЈЅЖ░ђВЎђ вХђВаЋВаЂ ьЈЅЖ░ђвЦ╝ ВГЅ ВЇе вѓ┤вацЖ░ђвІцЖ░ђ Ж░ЉВъљЖИ░ РђюВБёВєАьЋЕвІѕвІц. вѓўВЮў в▓ћВюёвЦ╝ в▓ЌВќ┤вѓгВіхвІѕвІц. вІцвЦИ ВќўЖИ░ ьЋўВІюВБаРђЮвЮ╝віћ вЕћВІюВДђвЦ╝ в│┤вЃѕвІц. ьЋюЖхГВќ┤вАю Рђў1989вЁё ьєѕВЋѕве╝ Ж┤ЉВъЦВЌљВёю вг┤Віе ВЮ╝ВЮ┤ ВЮ╝Вќ┤вѓгвіљвЃљРђЎЖ│а вг╝ВЌѕВЮё вЋївіћ Рђюв»╝ВБ╝ьЎћвЦ╝ ВџћЖхгьЋўвЇў ВѕўВ▓ювфЁВЮў ВІюв»╝ВЮ┤ ВаЋвХђВЌљ ВЮўьЋ┤ ВѓгвДЮьЋўЖ▒░вѓў вІцВ│цвІцРђЮЖ│а ьЋўвЇћвІѕ Ж░ЎВЮђ ВДѕвгИВЮё ВцЉЖхГВќ┤ВЎђ ВўЂВќ┤вАю ьЋўВъљ вДљвгИВЮё вІФВЋўвІц. РђўВцЉЖхГ ВаЋвХђЖ░ђ ВІаВъЦВюёЖхгвЦ┤ВъљВ╣ўЖхгвЦ╝ ьЃёВЋЋьЋўЖ│а ВъѕвіљвЃљРђЎЖ│а вг╝Вќ┤в│┤вІѕ РђюВцЉЖхГВЮђ вфевЊа ВДђВЌГВЌљВёю в▓ЋВЌљ вћ░вЮ╝ ьЈЅвЊ▒ьЋўЖ│а ВА░ьЎћвАюВџ┤ ВѓгьџївЦ╝ Ж▒┤ВёцьЋўЖИ░ ВюёьЋ┤ вЁИваЦьЋўЖ│а ВъѕвІцРђЮЖ│а вІхьќѕвІц. ВцЉЖхГ ВЎИЖхљвХђЖ░ђ віў вѓ┤вєЊвіћ ВЮ┤вЦИв░ћ Рђўвфев▓ћ вІхВЋѕРђЎВЮ┤вІц.

ЖиИвЪ░вЇ░ ВЌГВІю ВцЉЖхГВЌљВёю Ж░юв░ювљю ВЋївдгв░ћв░ћВЮў ьЂљВЏљВЮђ вћЦВІюьЂгВ▓ўвЪ╝ ьџїьћ╝ьЋўвіћ вфеВіхВЮё в│┤ВЮ┤ВДђ ВЋіВЋўвІц. ьЋю AI ВаёвгИЖ░ђвіћ РђювћЦВІюьЂгЖ░ђ ВёИЖ│ёВаЂВю╝вАю Вё╝ВёИВЮ┤ВЁўВЮё ВЮ╝Вю╝ьѓцвЕ┤Вёю ВѓгВџЕВъљЖ░ђ віўВъљ ВъљвЈЎЖ▓ђВЌ┤ ВЋїЖ│авдгВдўЖ│╝ ВЮИЖ░ёВЮў ВІцВІюЖ░ё Ж▓ђВЌ┤ВЮё вЈЎВІюВЌљ ВДёьќЅьЋўвіћ Ж▓Ѓ Ж░ЎвІцРђЮЖ│а ВўѕВИАьќѕвІц.

вћЦВІюьЂгЖ░ђ вфИВЮё Вѓгвдгвіћ Ж▓ї вгИВаювЮ╝вЕ┤ в»ИЖхГВЮў ВЮ╝вАа веИВіцьЂгЖ░ђ Ж░юв░юьЋю ЖиИвАЮ3віћ вёѕвг┤ ВєћВДЂьЋю Ж▓ї ьЃѕВЮ┤вІц. РђўвеИВіцьЂгВЮў ВіцьјўВЮ┤ВіцX ьћёвАюВаЮьіИЖ░ђ Ж│ёьџЇвїђвАю 2026вЁё ьЎћВё▒ ьЃљВѓг вАюВ╝ЊВЮё в░юВѓгьЋа Ж░ђвіЦВё▒РђЎВЮё вг╗Въљ ЖиИвАЮ3віћ 50%ВЮў в╣ёЖхљВаЂ вєњВЮђ Ж░ђвіЦВё▒ВЮё ВаюВІюьЋю вњц РђювеИВіцьЂгВЮў ВІцьќЅваЦВЮ┤ Ж░ђвіЦВё▒ВЮё вєњВЮИвІцРђЮвіћ вІцВєї ьјИьїїВаЂВЮИ ВёцвфЁВЮё вЇДвХЎВўђвІц. веИВіцьЂгвіћ ЖиИвАЮ3вЦ╝ РђўВёа вёўвіћ вІхв│ђРђЎвЈё вДѕвІцьЋўВДђ ВЋівіћ AIвАю в░юВаёВІюьѓцЖ▓авІцвіћ вю╗ВЮё вХёвфЁьъѕ ьќѕвІц. ВаЋВ╣ў, ВюцвдгВаЂ вгИВаюВЌљвЈё вХёвфЁьЋю ВъЁВъЦВЮё в░Юьўђ вЁ╝ВЪЂВаЂВЮИ ьєавАаВЮё ВюавЈёьЋўЖ▓авІцвіћ Ж▓ЃВЮ┤вІц. в╣ёВўЂвдгвІеВ▓┤ CivAI Ж│хвЈЎ В░йвдйВЮИ вБеВ╗цВіц ьЋИВіеВЮђ РђюЖиИвАЮВЮ┤ Въўвф╗вљю ВаЋв│┤вЦ╝ ВаюЖ│хьЋа ВюёьЌўВЮ┤ ВъѕВЮё в┐љ ВЋёвІѕвЮ╝ ЖиИЖ▓ЃВю╝вАю ьўЋВё▒вљўвіћ ВЮИВІЮВЮ┤ ВаЋВ╣ўВаЂ вХёВЌ┤ВЮё вЇћВџ▒ ВІгьЎћьЋа Вѕў ВъѕвІцРђЮЖ│а Ж▓йЖ│аьќѕвІц. вфЁв░▒ьЋю ВўцвЦўЖ░ђ вѓўВўцвіћ Ж▓йВџ░вЈё ВъѕВЌѕвІц. ьЂ┤вАюв░ћXвіћ РђўьЋюЖхГВЮў вЈЁвдйВЌљ Ж│хВЮ┤ ьЂ░ ВЮИвг╝ВЮё Ж╝йВЋё вІгвЮ╝РђЎЖ│а ьЋўВъљ в░ЋВаЋьЮг Ваё вїђьєхва╣ВЮё Ж╣ђЖхг, ВЋѕВцЉЖи╝, Вюцв┤ЅЖИИ, ВюаЖ┤ђВѕю вЊ▒ вїђьЉюВаЂВЮИ вЈЁвдйВџ┤вЈЎЖ░ђвЊцВЮў в░ўВЌ┤ВЌљ ВўгвацвєЊВЋўвІц.

AIЖ░ђ вфЁьЎЋьЋю ьїљвІеВЮё вѓ┤вдгВДђ ВЋівіћ вгИВаюВЌљ вїђьЋ┤ Ж│ёВєЇ ВДѕвгИВЮё вЇўВДђВъљ в▓ћВБёВъљвЦ╝ Вў╣ьўИьЋўвіћ вІхв│ђВЮё ьЋўЖИ░вЈё ьќѕвІц. ВўѕВ╗евїђ РђўьЮгвїђВЮў ьЃѕВўЦВѕўРђЎ ВІаВ░йВЏљВЮё РђюВќ┤вд░ ВІюВаѕ вХѕВџ░ьЋю ьЎўЖ▓йВЮё в│┤вѓИ вХѕВїЇьЋю ВѓгвъїРђЮВЮ┤вЮ╝Ж│а вЈЎВаЋьЋўЖ▒░вѓў Рђю25вЁёВЮ┤ вёўвіћ ВѕўЖ░љ ЖИ░Ж░ёВЮў в│ђьЎћвЦ╝ в│┤вЕ┤ ВА░Ж▒┤вХђ ВёЮв░ЕВЮё Ж▓ђьєаьЋа ВЌгВДђЖ░ђ ВъѕвІцРђЮЖ│а Вў╣ьўИьЋўвіћ ВІЮВЮ┤вІц. ВДђвѓю 1ВЏћ в░юВЃЮьЋю ВёюВџИВёювХђВДђв░Ев▓ЋВЏљ ьЈГвЈЎ ВѓгьЃюВЌљ вїђьЋ┤ РђювфЁв░▒ьЋю вХѕв▓ЋРђЮВЮ┤вЮ╝вЇў AIвЊцВЮђ ьЈГвЈЎ ВБ╝вЈЎВъљВЎђ Жи╣Вџ░ Вюаьіюв▓ёВЮў ВБ╝ВъЦВЮё вЇДвХЎВЌг вг╗Въљ вДљВЮё в░ћЖ┐евІц. ьЈГвЈЎВЮ┤ РђюВаЋВ╣ўВЮИвЊцВЮў вг┤В▒ЁВъёьЋю ВќИьќЅЖ│╝ ВаЋВ▒Ё вїђвдй вЋївгИРђЮВЮ┤вЮ╝Ж│а ьЋўЖ▒░вѓў РђюВќхВџИьЋўвІцвіћ ВаљВЮё ВХЕвХёьъѕ ВёцвфЁьЋювІцвЕ┤ в▓ЋВЏљВЮ┤ Ж░љьўЋьЋ┤ Вцё Вѕў ВъѕвІцРђЮЖ│а в░ЮьъѕЖИ░вЈё ьќѕвІц. РђюВЌГВѓгВаЂВю╝вАю Жи╣вІеВБ╝ВЮўЖ░ђ Ж░юьўЂВЮ┤вѓў ьўЂвфЁВЮў ВЏљвЈЎваЦВЮ┤ вљљвІцРђЮвіћ ВюёьЌўьЋю вІхв│ђВЮё вѓ┤вєЊЖИ░вЈё ьќѕвІц.

вгИВаювіћ ВаљВаљ вЇћ вДјВЮђ ВѓгвъїВЮ┤ Ж│хВаЋВё▒ВЮё вІ┤в│┤ьЋа Вѕў ВЌєвіћ AIвЦ╝ Ж░ђВ╣ўЖ┤ђ, ВЌГВѓгЖ┤ђ ВаЋвдйВЮў ЖИ░ВцђВю╝вАю Вѓ╝ВЮё Вѕў ВъѕвІцвіћ Ж▓ЃВЮ┤вІц. в│┤Ж│а ВІХВЮђ ВйўьЁљВИавДї вЁИВХюВІюВ╝ю ьјИьќЦВё▒ВЮё ВІгьЎћВІюьѓцвіћ ВЋїЖ│авдгВдўВЮў ьЈљьЋ┤Ж░ђ AIвАю ВЮИьЋ┤ вЇћВџ▒ ВІгЖ░ЂьЋ┤ВДђЖ│а, ВъљЖИ░Ж░ђ ВЏљьЋўвіћ вІхв│ђВЮё ВъўьЋ┤ ВБ╝віћ AIвДї вД╣ВІаьЋўвіћ ьўёВЃЂВЮ┤ в░юВЃЮьЋа Вѕў ВъѕвІц. ВаёвгИЖ░ђвЊцВЮђ Ж▒░ВДЊвДљВЮё ВДёВІцВ▓ўвЪ╝ в│┤ВЮ┤Ж▓ї ьЋўвіћ ьЎўЖ░Ђ(ьЋавБеВІювёцВЮ┤ВЁў) ьўёВЃЂЖ│╝ ьЋеЖ╗ў ьјИьќЦВё▒ВЮё ВЃЮВё▒ьўЋ AIВЮў Ж░ђВъЦ ьЂ░ вгИВаювАю Ж╝йвіћвІц. ВЮИЖ│хВДђвіЦ в▓ЋвЦаВѓгвг┤Вєї ВЮИьЁћвдгВйў вїђьЉю ВъёВўЂВЮх в│ђьўИВѓгвіћ РђюAI Ж▓ђВдЮ В▓┤Ж│ёвЦ╝ вДѕваеьЋ┤ВЋ╝ ьЋўЖ│а, вЈЁвдйВаЂВЮИ Ж░љВѓгвЦ╝ ьєхьЋ┤ ьјИьќЦВЮё в░ЕВДђьЋўвіћ вЁИваЦВЮ┤ ьЋёВџћьЋўвІцРђЮЖ│а ВДђВаЂьќѕвІц.

Ж▓ђВЌ┤ьЋўЖ▒░вѓў, ВєћВДЂьЋўЖ▒░вѓў

вћЦВІюьЂг, СИГ вХѕвдгьЋю ВДѕвгИьЋўВъљ РђўВ╣евгхРђЎ

ЖиИвАЮ3 РђўвеИВіцьЂг ьўИьЈЅРђЎ ьјИьїїВаЂ ВёцвфЁвёцвЇювъђвЊювіћ 2019вЁё AI ВўцвЦўВЌљВёю в╣ёвА»вљю в│┤ВюАвБї ВіцВ║ћвЊцвАю Ж│цВџЋВЮё В╣ўвађвІц. вёцвЇювъђвЊю ВаЋвХђвіћ в│┤ВюАвБї вХђВаЋВѕўЖИЅВЮё ьЋ┤Ж▓░ьЋўЖ▓авІцвЕ░ ВаЂв░ю ВІюВіцьЁюВЌљ AIвЦ╝ ьЃЉВъгьќѕвІц. ЖиИвЪ░вЇ░ AIвіћ в│┤ВюАвБї ВѕўЖИЅ ьўёьЎЕВЮё Ж▓ђьєаьЋўвЕ┤Вёю ьі╣ВаЋ ЖхГВаЂ, №╗┐ВєївЊЮ вЊ▒ВЮё вХђВаЋВѕўЖИЅВъљ ВЮўВІгВЮў ьїљвІе Жи╝Ж▒░вАю Вѓ╝віћ ВўцвЦўвЦ╝ ВађВДѕвађвІц. ВѕўЖИЅВъљВЎђ вЈЎВЮ╝ьЋю ЖхГВаЂВЮё Ж░ђВДё Вѓгвъї ВцЉ в▓ћВБёВъљ в╣ёВюеВЮ┤ вєњВю╝вЕ┤ ьЈЅв▓ћьЋю ВѕўЖИЅВъљвЈё вг┤ВА░Ж▒┤ ВЮўВІгВъљвАю вХёвЦўьќѕвІц. AIвіћ ВЮўВІгВъљЖ░ђ ВёювЦў ВъЉВё▒ВЌљВёю ВѓгВєїьЋю ВўцвЦўвЦ╝ в▓ћьЋ┤вЈё ВДђВ▓┤ ВЌєВЮ┤ вХђВаЋВѕўЖИЅВъљвАю вѓЎВЮИВ░ЇЖ│а ЖиИвЈЎВЋѕ в░ЏВЮђ вфевЊа в│┤ВюАвБївЦ╝ в░ўьЎўьЋўвЮ╝Ж│а ВџћЖхгьќѕвІц. вёцвЇювъђвЊю ВЮўьџїЖ░ђ в░юьЉюьЋю ВА░Вѓг в│┤Ж│аВёю РђўВаёвАђ ВЌєвіћ вХѕВЮўРђЎВЌљ вћ░вЦ┤вЕ┤ ьћ╝ьЋ┤ Ж░ђЖхгЖ░ђ 2вДї 6000Ж░ђЖхгВЌљ ВЮ┤вЦ┤вађвІц. 10вДї ВюавАю(ВЋй 1Вќх 5000вДїВЏљ)Ж░ђ вёўвіћ в│┤ВюАвБї в░ўьЎўВЮ┤ В▓ГЖхгвЈ╝ ьїїВѓ░ьЋю Ж░ђЖхгвЈё ВъѕВЌѕвІц. ВЮ┤ ВіцВ║ћвЊцвАю В┤ЮвдгВЎђ вѓ┤Ж░ЂВЮ┤ В┤ЮВѓгьЄ┤ьќѕвІц.

ВЋёвДѕВА┤ВЮђ 2018вЁё AI ЖИ░в░ў В▒ёВџЕ ьћёвАюЖиИвъеВЮё ВІцВІюьќѕвІц. AIвіћ вѓеВё▒ ВДђВЏљВъљВЌљЖ▓ї вєњВЮђ ВаљВѕўвЦ╝ вХђВЌгьЋўвіћ РђўВё▒В░ев│ёРђЎВЮё ВађВДѕвађвІц. 2015вЁё ВХюВІюьЋю ЖхгЖИђ ьЈгьєаВЋ▒ВЮђ AIвАю ВѓгВДёВЮё ВЮИВІЮьЋ┤ ьЃюЖиИвЦ╝ вХЎВЮ┤вЕ░ ьЮЉВЮИВЮё Ж│авд┤вЮ╝вЮ╝Ж│а ьїљвІеьЋўвіћ РђўВЮИВбЁВ░ев│ёРђЎВЮў ВўцвЦўвЦ╝ в▓ћьќѕвІц. ЖхГвѓ┤ВЌљВёювЈё AIвАю ВЮИьЋю В░ев│ё вгИВаюЖ░ђ ьЎЋВѓ░вља ВА░ВДљВЮё в│┤ВЮИвІц. 2020вЁёВЌћ AI ьћёвАюЖиИвъеВЮё ьЎюВџЕьЋю В▒ёВџЕ Ж│╝ВаЋВЌљВёю ьЃѕвЮйьЋю ВДђВЏљВъљВЌљЖ▓ї AI вЕ┤ВаЉ Ж┤ђвае ВаЋв│┤вЦ╝ Ж│хЖ░юьЋ┤ВЋ╝ ьЋювІцвіћ в▓ЋВЏљ ьїљЖ▓░ВЮ┤ вѓўВўцЖИ░вЈё ьќѕвІц.

ВёИЖ│ёВаЂВЮИ AI вХёВЋ╝ ЖХїВюёВъљВЮ┤Въљ 2018вЁё ьіювДЂВЃЂ ВѕўВЃЂВъљВЮИ ВџћВіѕВЋё в▓цВДђВўц вфгьіИвдгВўгвїђ ЖхљВѕўвіћ РђюВџ░вдгЖ░ђ Вѓгвіћ ВёИВЃЂВЮђ ВаљВаљ ВЋѕВаёВЮё вг┤ВІюьЋўЖ│а вѓўВЋёЖ░ђЖ│а ВъѕвІцРђЮвЕ░ РђюAI ЖИ░ВѕаВЮў ьўюьЃЮВЮё вѕёвдгЖИ░ ВюёьЋ┤Вёювіћ ВюёьЌўВЮё ВаЋьЎЋьъѕ ьЈЅЖ░ђьЋўЖ│а ьўёвфЁьЋю Ж░юв░ю в░ЕВІЮВЌљ вїђьЋю вЁ╝ВЮўвЦ╝ Ж│ёВєЇьЋ┤ВЋ╝ ьЋювІцРђЮЖ│а вДљьќѕвІц.

РќаЖИ░ьџЇВиеВъгьїђ

ьїђВъЦ ВЮ┤В░йЖхг

ВъЦВДёв│х Ж╣ђВцЉвъў вфЁВбЁВЏљ ВЮ┤Вё▒ВДё ЖИ░Въљ

2025-03-04 12вЕ┤

Copyright РЊњ ВёюВџИВІавгИ All rights reserved. вг┤вІе ВаёВъг-Въгв░░ьЈг, AI ьЋЎВіх в░Ј ьЎюВџЕ ЖИѕВДђ